| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- BFS

- MySQL

- YoLO

- hm3d

- hm3dsem

- C++

- image processing

- r-cnn

- deep learning

- ubuntu

- DP

- Python

- 머신러닝

- UC Berkeley

- Reinforcement Learning

- 그래프 이론

- LSTM

- dfs

- dynamic programming

- CS285

- 강화학습

- NLP

- machine learning

- 딥러닝

- opencv

- AlexNet

- CNN

- GIT

- RL

- 백준

- Today

- Total

JINWOOJUNG

3D Scene Graph: A Structure for Unified Semantics, 3D Space, and Camera 본문

3D Scene Graph: A Structure for Unified Semantics, 3D Space, and Camera

Jinu_01 2025. 7. 17. 21:02Paper

https://arxiv.org/pdf/1910.02527

https://3dscenegraph.stanford.edu/images/supp_mat.pdf

Introduction

객체 및 공간의 기하학적 구조, 카테고리(클래스), 특정 장면의 시점 등의 정보를 효과적으로 저장하는 것은 매우 중요한 문제이다. 이러한 정보를 저장하기 위한 이상적인 공간은 변화에 불변 즉, 전체적인 공간적 정보를 불변하게 모두 포괄해야 한다. 또한, 이미지나 비디오 등 다양한 도메인에 쉽고 결정론적으로 연결되어야 한다. 이러한 측면에서, 이미지는 이상적인 해결책이 되지 않는다. 이미지는 시점에 따른 제약이 존재하며, Depth/Size 등의 정보를 효과적으로 다루지 못한다.

따라서 본 논문에서는 3D Scene Graph를 제안한다. 3D 공간은 2D(이미지)보다 더 안정적이고 불변하다. 또한, 다른 공간(이미지, 비디오) 등에 쉽게 투사할 수 있다. 이는 amodal(비양상, 가려진 부분을 포함하는 온전한 형태의 정보 추출 가능), occlusion 등에 강점을 가진다. 또한, 임의의 시야에 투사할 수 있다. Scene Graph는 단순한 객체 클래스보다 더 다양한 표현이 가능하며, 자연어 캡션보다 더 많은 구조와 불변성을 가진다.

본 논문에서의 기여도는 다음과 같다.

- 기존 Scene Graph 아이디어를 3D 공간으로 확장, Semantic Information을 처리한다.

- 불완전한 기존 검출기를 사용해여 Semantic Recognition을 최적화 하기 위한 2단계 강화 접근 방식을 제안한다.

- 실제 세계 데이터셋인 Gibson Environment's Database를 3D Scene Graph로 보강한다.

3D Scene Graph Structure

본 논문에는 계층화 된 3D Scene Graph를 제안한다. 자동화 된 Semantic Annotation 생성 및 3D Scene Graph 생성을 위해서 Input은 3D Mesh Model이 된다. Output은 Figure 1의 3D Scene Graph이다.

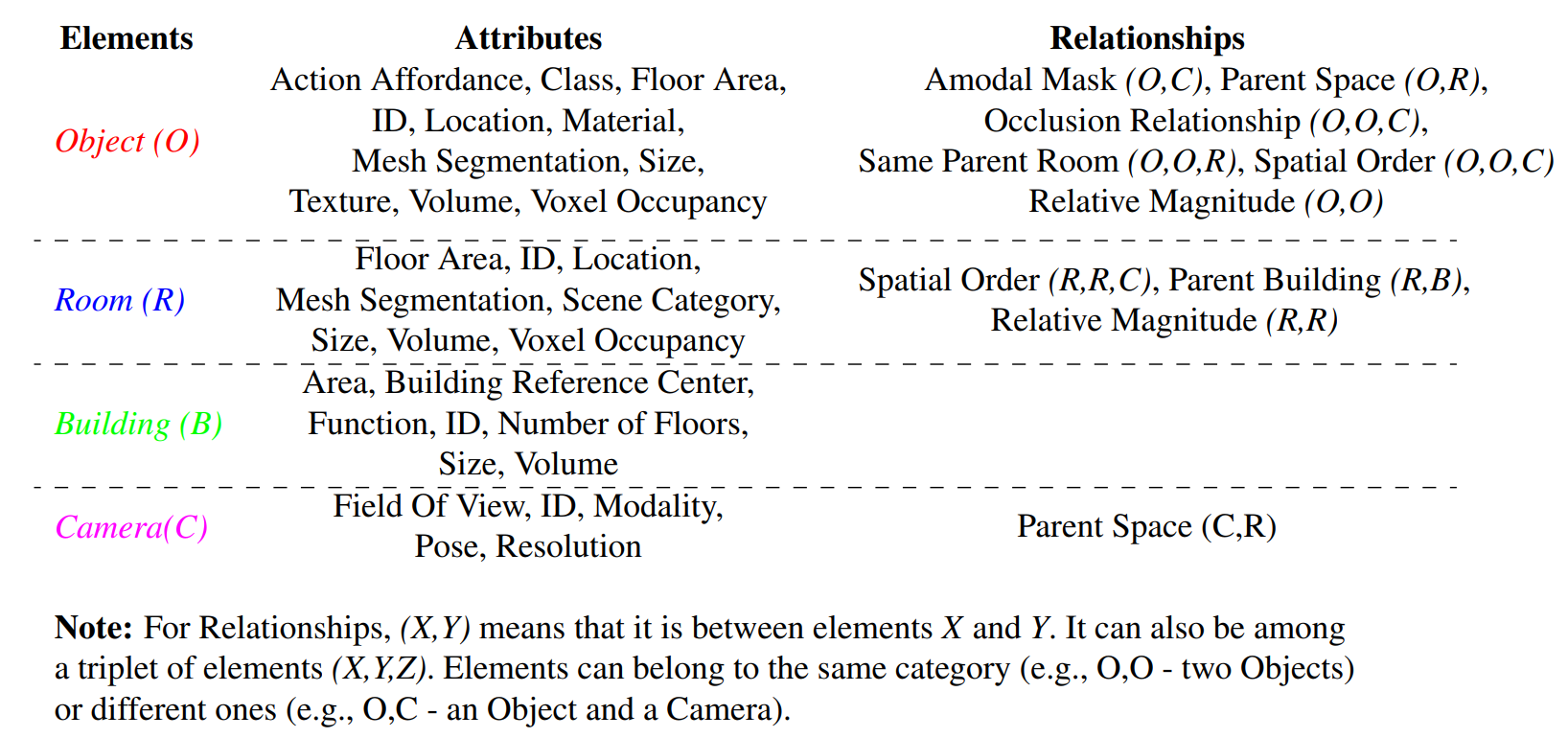

3D Scene Graph는 4계층(4 Layer) 그래프이며, 각 Layer는 노드(Node) 집합으로 구성, 각 노드는 속성(Attribute) 집합을 가지며, 노드간의 관계는 엣지(Edge)로 정의된다. First Layer는 전체 건물 즉, 주어진 3D mesho model을 의미하며, 이를 대표하는 root node를 포함한다. Second Layer는 건물을 구성하는 방으로 구성되며, 각 방은 고유한 노드로 표현된다. Third Layer는 각 방에 속하는 객체들로 구성되며, 각 객체는 고유한 노드로 표현된다. Fourth Layer는 카메라들의 집합이며, 각 카메라의 위치가 고유한 노드로 표현되고, 이는 각 위치에서 취득한 이미지와 연결된다.

각 노드는 속성(Attribute)를 가진다. 각 Layer의 노드에 따라 다르며, 예를 들면 객체 클래스, 재료 유형, 위치, 자세 등이다. 또한, 노드들은 엣지(Edge)로 연결되며, 이는 두 노드 간의 관계(Relationships)를 의미한다. 관계는 동일 계층의 노드간의 관계도 정의되지만, 서로 다른 계층간의 관계로도 정의된다.

각 노드에 따른 Attributes, Relationships는 위와 같다.

Attributes는 각 객체들의 정보들을 세부적으로 표현하는 정보라고 생각하면 된다. 이때, Action Affordance는 해당 객체에서 가능한 Action을 의미한다. 예를 들어, 침대인 경우 lay on, sti on 이 해당된다.

Relationships는 Edge에 저장되는 노드들간의 관계이다. 이때, (O,O,C)는 2개의 Object와 Camera로, Occlusion Relationship의 의미는 해당 카메라로 취득한 이미지 상에서 두 객체들이 포함되는지를 의미하는 관계이다. 또한, Same Parent Room은 두 객체가 동일한 Room에 있는지를 의미하는 관계이다. Relationships는 노드들의 정보들이 각 노드로 저장된다면 자동적으로 생성할 수 있다.

Appendix

본 논문을 가져온 이유는 3D 공간상에서의 Dataset 구축을 위해서는 3D 공간의 Semantic Information을 효과적으로 다룰 수 있어야 하기 때문에 가져왔다. Annotation이 존재한다면, 각 노드들의 Attributes는 쉽게 생성할 수 있고, 이를 기반으로 Relationships를 Task에 맞게 설정한다면 매우 효과적으로 3D Scene을 표현하는 방법이라고 생각한다.

직접 구현할때는 Python networks의 Graph를 이용해서 구현하였다. 관련한 참고 자료는 다음과 같다.

https://www.youtube.com/watch?v=rOCxA8A3es4

'NLP, LLM, Multi-modal' 카테고리의 다른 글

| BAT: Learning to Reason about Spatial Sounds with Large Language Models (0) | 2025.07.04 |

|---|---|

| 3D Concept Learning and Reasoning from Multi-View Image (1) | 2025.06.26 |

| Habitat-Matterport 3D semantic dataset (0) | 2025.06.25 |

| SoundSpaces 2.0: A Simulation Platform for Visual-Acoustic Learning (0) | 2025.06.22 |

| [ Transformer to LLaMA ] ELMo: Embeddings from Language Models (0) | 2025.04.28 |