| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- GIT

- 그래프 이론

- hm3dsem

- YoLO

- CNN

- LSTM

- opencv

- dfs

- 머신러닝

- machine learning

- dynamic programming

- AlexNet

- UC Berkeley

- 백준

- hm3d

- 딥러닝

- 강화학습

- NLP

- Python

- deep learning

- r-cnn

- RL

- C++

- image processing

- MySQL

- CS285

- Reinforcement Learning

- BFS

- DP

- ubuntu

- Today

- Total

JINWOOJUNG

[RL] CS285: Lecture 01. Introduction 본문

본 포스팅은 UC Berkeley 에서 진행된 CS285: Deep Reinforcement Learning, Decision Making and Control

강의자료 및 강의를 기반으로 공부한 내용을 정리하는 포스팅입니다.

Introduction

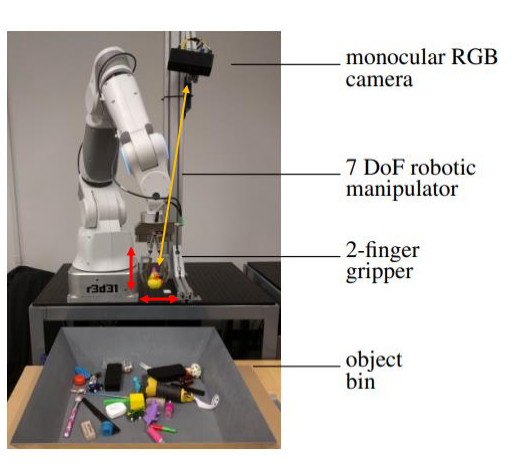

다음과 같은 Robot이 있다고 가정하자. RGB camera를 통해 객체들을 볼 수 있으며, 7 자유로들 가진 manipulator를 통해 객체들을 조작할 수 있다.

그리고 우리에게 주어진 Task는 특정 물체를 집어 통 밖으로 꺼낸다고 가정하자. 그러면 우리는 입력받은 이미지를 통해 우리의 방법론을 통해 물체를 집을 (x,y,z) 좌표를 만들어야 한다.

그렇다면 2가지 방법이 있을 것이다.

첫번째 방법은 Hard coding 하는 방법이다. 하지만, 수많은 객체들에 대해서 특성을 이해하고, 그에 따라 서로 다른 동작을 취하도록 하는 것은 불가능하다.

두번째 방법은 이를 machine learning problem으로 생각하는 것이다. 하지만, 지도학습에서 요구되는 Data가 이러한 Robotics 관련된 task에서는 부족한 것이 현실이다. 즉, 다양한 객체들의 특성과 로봇 움직임을 고려한 최적의 정답 Data를 생성하는데 한계가 있고, 그렇기에 Reinforcement Learning(강화학습) 방법론이 필요한 것이다.

최근 AI가 발전하면서 많은 연구가 진행되고 있지만, 결국 지도학습 기반 모델은 본질적으로 사람이 만든 데이터와 정답에 의존한다. 입력이 주어졌을 때 사람이 달아준 정답(Ground Truth)을 최대한 잘 따라 하도록 학습되기 때문에, 결국 모델의 최고 성능은 라벨을 만든 사람 집단의 판단 수준과 편향을 크게 벗어나기 어렵다.

하지만, 강화학습은 사람이 생각지 못한 결과를 발생할 수 있다. 정답 레이블 대신 보상(Reward)만을 이용해, Agent가 환경과 상호작용하여 다양한 행동을 탐색(Search)한다. 이 과정에서 사람이 생각하지 못한 전략이나 정책을 발견하기도 하며, 때로는 사람의 수준을 능가하는 해결책을 찾아낼 수 있다.

What is reinforcement learning?

강화학습이란 경험으로부터 의사 결정과 제어를 학습하기 위한 접근법이라고 정의할 수 있다.

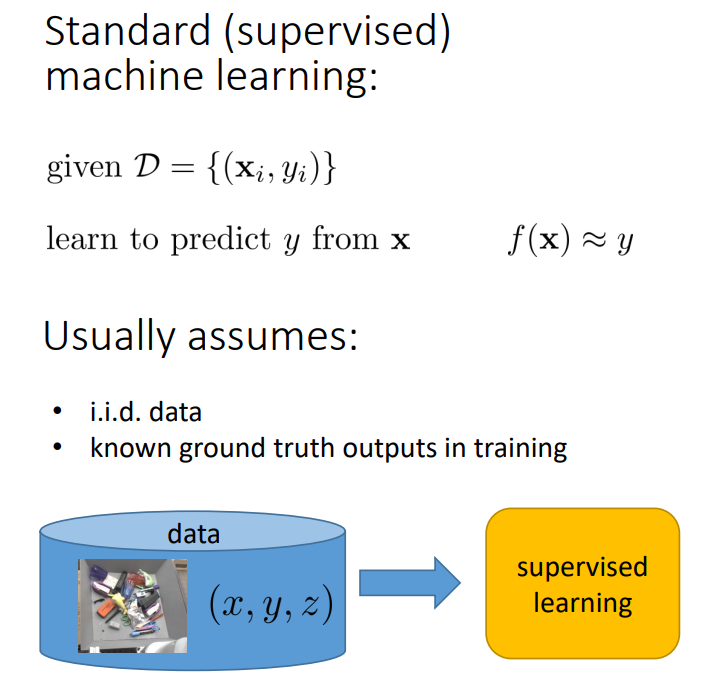

우리가 일반적으로 알고 있는 Standard(supervised) machine learning 즉, 지도학습은 입력 $x$와 출력 $y$로 구성된 데이터 $D$가 주어졌을 때, $x$로부터 $y$를 예측할 수 있다록 학습하는 것이다.

이때, $D$는 i.i.d(independent identically distributed) 데이터라고 가정한다. 이는, Dataset의 모든 $x,y$ 쌍은 다른 쌍과 독립적이며, 각 Data를 생성할 때 동일한 분포를 따름을 의미한다. 또한, 학습 과정에서 Ground Truth 를 알고 있다고 가정한다.

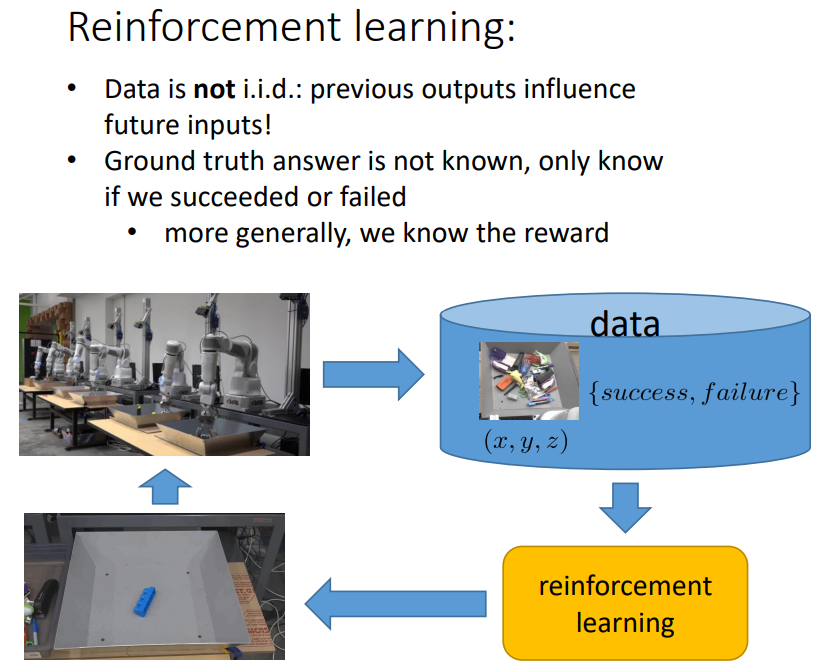

하지만, 강화학습의 데이터는 i.i.d 데이터가 아니다. 또한, Ground Truth는 알지 못하며, 성공과 실패 여부만 알 수 있다.

조금 더 자세히 살펴보면, 특정 작업을 실패한 경우 그 행동을 그데로 사용하는 것이 불가능하다. 또한, 실패나 성공을 했다 하더라도 명확한 해석이 불가능하다. 수많은 Action이 반복되어 실패나 성공을 결정하였기에, 어느 Action이 이유인지 명확하게 해석하기 어렵다. 이는 인간의 의사 결정과 유사하다고 할 수 있다.

지도학습과 강화학습을 수학적으로 조금 더 살펴보자.

결국, 지도학습은 데이터를 기반으로 $f_\theta$을 학습하는 것이며, 강화학습은 $\pi_\theta$를 학습하는 것이다.

이때, $\pi_\theta$는 total rewards의 누적 합을 최대로 하는 것(Optimization)을 목표로 한다.

정리하자면, Data 기반의 AI는 Data보다 더 좋아질 수 없는 한계를 가지지만, 강화학습은 최적화를 통해 새로운 방법론을 탐색할 수 있다.

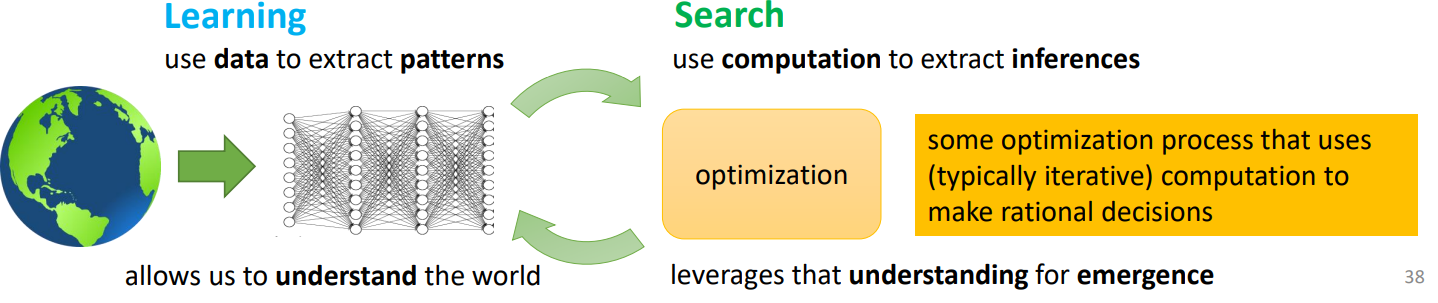

Computer Vision 분야에서 강화학습의 대가이신 Richard Sutto 교수님은 다음과 같이 말했다.

The two methods that seem to scale arbitrarily are learning and search

즉, 성능을 향상시키기 위해선 GPU, Data 등이 아니라, 학습하고 탐색하는 과정이 요구된다. 이때, 학습(Learning)은 세계를 이해하기 위해 패턴(특징)을 추출하기 위해 데이터를 활용하는 과정이며, 탐색(Search)는 단순히 데이터를 많이 얻는 것이 아니라 합리적 의사 결정 추론을 위해 최적화하는 과정이다. 그리고 이는 강화학습으로 연결된다!!

'Reinforcement Learning' 카테고리의 다른 글

| [RL] CS285: Lecture 02. Supervised Learning of Behaviors(2) (0) | 2025.12.14 |

|---|---|

| [RL] CS285: Lecture 02. Supervised Learning of Behaviors(1) (0) | 2025.12.14 |

| Deep Reinforcement Learning (1) | 2024.02.05 |

| Value Function Approximation (0) | 2024.02.04 |

| Model-based RL (1) | 2024.01.28 |