| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- image processing

- MySQL

- machine learning

- Python

- CNN

- hm3d

- ubuntu

- AlexNet

- dfs

- 강화학습

- dynamic programming

- BFS

- CS285

- deep learning

- Reinforcement Learning

- RL

- opencv

- UC Berkeley

- C++

- LSTM

- NLP

- 그래프 이론

- 머신러닝

- GIT

- YoLO

- 백준

- 딥러닝

- r-cnn

- DP

- hm3dsem

- Today

- Total

JINWOOJUNG

[RL] CS285: Lecture 04. Introduction to Reinforcement Learning(2) 본문

[RL] CS285: Lecture 04. Introduction to Reinforcement Learning(2)

Jinu_01 2026. 1. 27. 18:20본 포스팅은 UC Berkeley 에서 진행된 CS285: Deep Reinforcement Learning, Decision Making and Control

강의자료 및 강의를 기반으로 공부한 내용을 정리하는 포스팅입니다.

https://jinwoo-jung.tistory.com/173

[RL] CS285: Lecture 04. Introduction to Reinforcement Learning(1)

본 포스팅은 UC Berkeley 에서 진행된 CS285: Deep Reinforcement Learning, Decision Making and Control강의자료 및 강의를 기반으로 공부한 내용을 정리하는 포스팅입니다.https://jinwoo-jung.tistory.com/170 [RL] CS285: Lecture

jinwoo-jung.com

Types of Algorithms

RL algorithms에 대해서 간단히 살펴보자

Model based RL algorithms

환경의 동작을 나타내는 Model을 사용(학습)해서 정책을 개선하는 Algorithm이다. 여기서 모델이란 $p(s_{t+1}|s_t, a_t), r(s,a)$등 전이 확률이나 보상 모델을 의미한다. 즉, 현재 상태에서 어떠한 행동을 하면 다음에 어떤 상태와 보상이 나오는지를 예측하는 환경의 수학적 표현이다.

여기서는 Improve the policy 단계를 집중적으로 살펴보자.

[1]은 따로 Policy 없이 Action sequence를 직접 최적화하는 알고리즘이다. [2]는 Backpropagation을 통해 Rewards의 기댓값을 최대화하는 방향으로 학습하는 방법이다. 즉, 환경(모델)을 미분하여 직접 Backprop 하는 방법이다. [3]은 모델은 Value function을 학습하는 데만 사용되고, Policy는 Value를 통해 개선하는 방법이다.

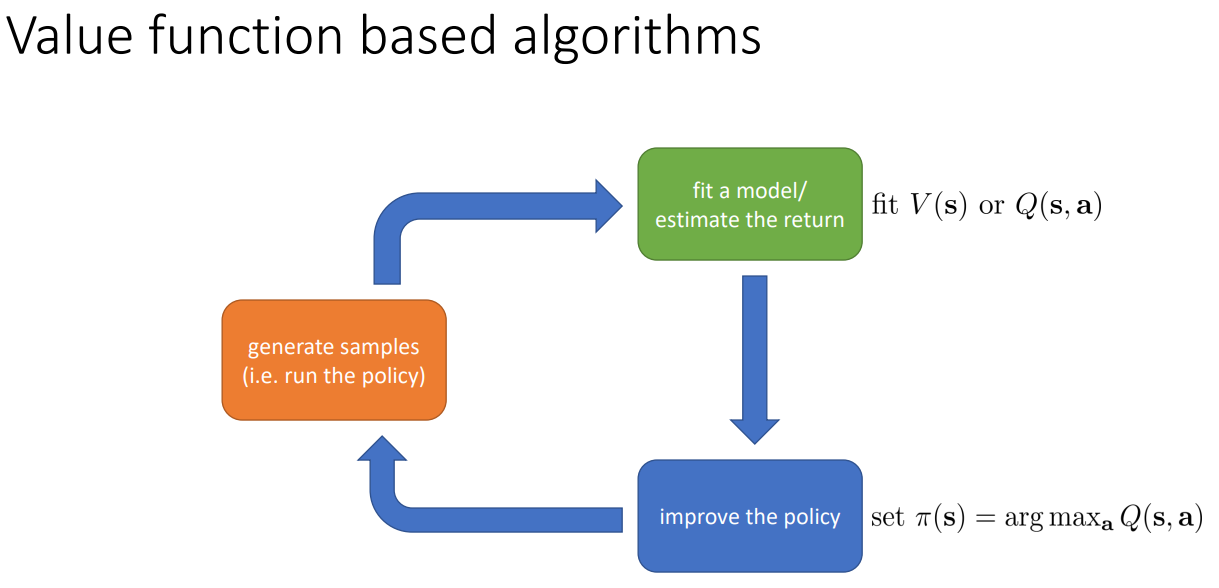

Value function based algorithms

Policy를 직접 학습하는 것이 아닌, Value function을 구해 argmax를 취함으로써 이 상태(행동)이 얼마나 좋은가를 먼저 학습한 뒤, 이를 기반으로 Policy를 개선하는 방법이다.

Actor-critic: value functions + policy gradients

2가지 방법을 합친 방법으로, Value function을 Estimate하여 Policy를 Update하는 방식이다.

Actor는 현재 Policy를 기반으로 Samples를 생성한다. Critic은 Value function을 통해 Actor의 행동을 평가하게 된다. 그 결과를 바탕으로 Actor는 Policy를 Update하는 방식이 Actor-critic이다.

Tradeoffs Between Algorithms

그렇다면 왜 이렇게 많은 알고리즘이 존재할까? 이는 어떤 RL algorithms를 선택함에 따라 각 특성에 대해 trade-offs가 발생하기 때문이다.

Sample efficiency는 좋은 Policy를 얻기 위해 얼마나 많은 Samples(times)가 필요한지를 의미한다. 이는 On-policy, Off-policy에 따라 나뉘게 된다.

- Off-policy: 새로운 Samples를 생성하지 않고, 이전에 생성한 samples를 재사용 가능

- On-policy: 매 Policy가 변함에 따라 새로운 Samples를 생성해야

알고리즘이의 On/Off policy인지에 따라 Samples를 생성하는 시간에 따른 효율성이 차이나기 때문이다.

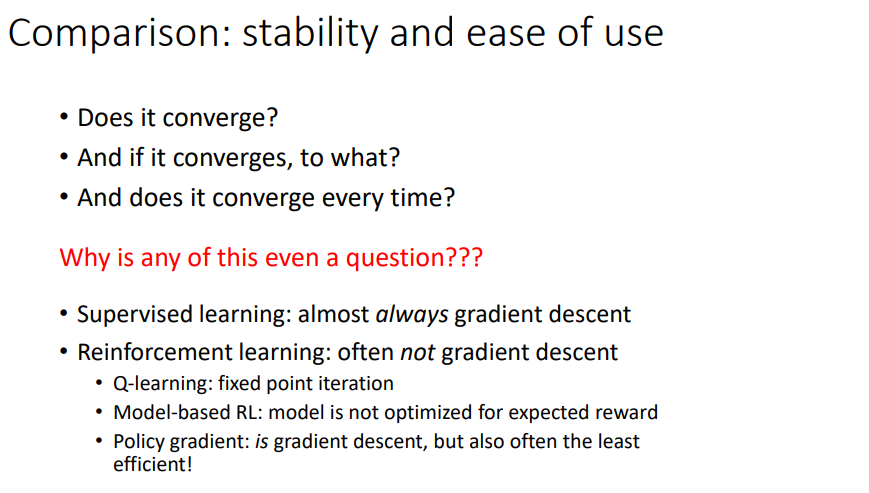

RL에서는 수렴성이 보장되지 않을 수 있다. 그렇기 때문에 연구를 하면서 이러한 질문들을 끊임없이 해야 한다.

따라서 RL에서는 몇몇 가정들을 자주 하기도 한다.

- Full observability: 현재의 관측 $s_t$가 환경의 전체 상태를 담고 있음을 의미한다. 이는 Markov property가 성립함을 의미하기도 한다. 주로 Value-based algorithm에서 사용된다.

- Episodic learning: 학습이 Episode 단위로 끊긴다. 즉, 유한한 길이의 Trajectory를 가진다. 주로 Policy gradient에서 사용된다.

- Continuity or smoothness: Dynamics, reward, value 등이 연속적이고 부드럽다. 주로 Model-based에서 사용된다.

'Reinforcement Learning' 카테고리의 다른 글

| [RL] CS285: Lecture 05. Policy gradients(2) (0) | 2026.01.28 |

|---|---|

| [RL] CS285: Lecture 05. Policy gradients(1) (0) | 2026.01.28 |

| [RL] CS285: Lecture 04. Introduction to Reinforcement Learning(1) (0) | 2026.01.27 |

| [RL] CS285: Lecture 02. Supervised Learning of Behaviors(2) (0) | 2025.12.14 |

| [RL] CS285: Lecture 02. Supervised Learning of Behaviors(1) (0) | 2025.12.14 |